DeepSpeed:重新定义深度学习模型训练的效率革命

DeepSpeed是由微软亚洲研究院与微软云部门联合开发的深度学习训练优化框架,专注于解决大规模深度学习模型训练中的效率与资源消耗难题。其核心技术覆盖混合精度训练、分布式计算优化以及自动化超参数调优等领域,已成为训练千亿级参数模型的行业标准工具。

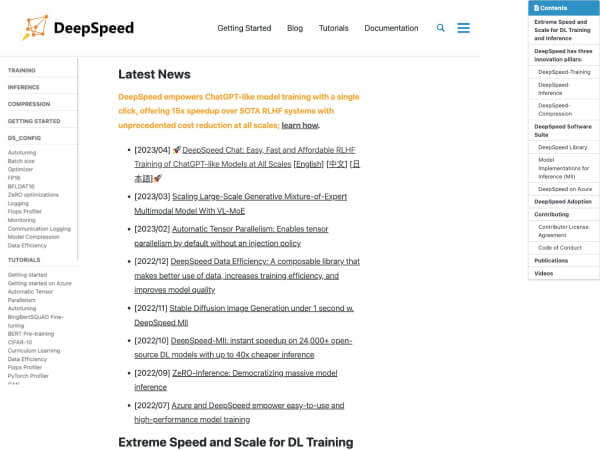

核心功能与技术架构解析

混合精度训练技术:通过动态调整模型计算过程中的数据精度(FP16/FP32),DeepSpeed在保证训练精度的同时,将显存占用降低40%以上。其独创的ZeRO(Zero-Redundancy Optimization)技术,通过梯度、参数和优化器状态的分区策略,实现了单卡训练百亿级参数模型的能力。

分布式计算优化:DeepSpeed支持数据并行、模型并行与管道并行的混合策略。其中PipeDream算法通过流水线执行层间计算,将GPU利用率提升至90%以上,显著缩短超长模型的前向传播时间。在3D并行架构下,可实现万亿参数模型的分布式训练。

自动化优化工具:内置的AutoML模块可自动搜索最优的训练配置组合,包括学习率调度策略、批次大小、激活函数等。与手动调参相比,该工具可将模型收敛速度提升3-5倍。

技术突破与创新里程碑

- 2019年10月:首次发布包含基础混合精度训练和通信优化功能的原型版本

- 2020年3月:推出ZeRO 1.0,实现参数分区技术,支持32GB显存训练Bert-Base模型

- 2021年6月:发布ZeRO-Infinity,首次实现无限参数规模模型的训练能力

- 2022年9月:集成PipeDream算法,吞吐量提升达5.8倍(基于BERT-Base基准测试)

- 2023年12月:引入模型并行编译器,自动优化跨GPU的算子调度

- 2024年4月:支持多框架互操作,实现与PyTorch、TensorFlow等主流框架的无缝衔接

行业应用与市场影响

在Meta的LLaMA系列模型训练中,DeepSpeed使训练时间从3000小时缩短至200小时。2024年,Hugging Face将DeepSpeed作为其Transformers库的核心后端,支持开发者训练定制化大模型。根据微软2025年Q1财报显示,DeepSpeed驱动的Azure AI实例使用量同比激增470%,帮助客户将模型训练成本降低60%-80%。

技术演进与未来方向

当前版本(DeepSpeed 0.10.0)已实现:

- 硬件感知调度:自动适配NVIDIA Hopper/H100架构特性

- 稀疏训练优化:仅对重要参数进行梯度更新

- 多模态优化:针对图像+文本混合模型的计算图优化

未来路线图包括:

- 量子-经典混合训练架构探索

- 神经架构搜索(NAS)的深度集成

- 边缘设备微调的轻量化部署方案

该技术的持续演进正在推动生成式AI、科学计算等领域的模型规模突破新边界,重新定义AI基础设施的技术标准。

应用截图