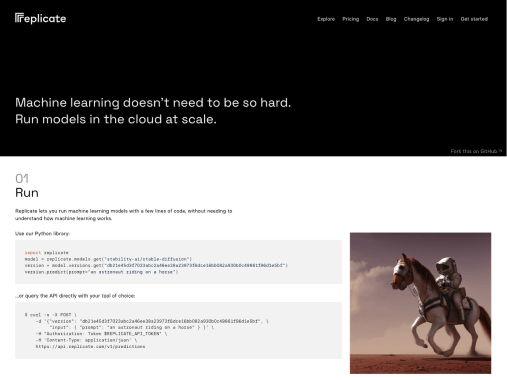

Replicate:重新定义AI模型部署与协作的云端平台

作为AI技术民主化浪潮中的重要参与者,Replicate自2021年成立以来,凭借其独特的容器化模型运行机制,迅速成为开发者与企业部署机器学习模型的首选工具。该平台通过标准化的API和直观的Web界面,将复杂的模型推理过程简化为“一键运行”,彻底改变了AI技术的应用门槛。

---

核心功能与技术架构

Replicate的核心优势体现在三个关键技术设计中:

1. 容器化模型仓库:所有模型均打包为Docker容器,开发者可通过`replicate.run`域名直接调用。这种设计确保了模型环境的隔离性,避免依赖冲突。

2. 零配置部署:用户无需管理服务器或GPU集群,平台按需动态分配计算资源,支持PyTorch、TensorFlow等主流框架。

3. API优先设计:提供标准化RESTful API接口,开发者可快速将模型集成到现有产品或服务中。例如,通过调用`/predictions`端点即可触发图像生成任务。

平台支持的热门模型包括Stable Diffusion、DALL·E 2、 Whisper等,覆盖文本生成、图像处理、音频分析等场景。其技术栈基于Python和Go语言构建,采用Kubernetes管理大规模分布式计算资源。

---

发展历程与关键里程碑

- 2021年成立:由Lukas Biewald(前Crowdflower创始人)与CTO Tim Hunter共同创立,初始团队仅有5人。

- 2022年种子轮融资:获得1300万美元融资,由A16z领投,用于扩展工程团队和模型库建设。

- 2023年重大更新:

- 推出Web UI界面,支持非技术人员直接操作模型

- 引入“版本控制”功能,支持模型迭代历史追踪

- 与Hugging Face建立合作,集成其模型库资源

- 2024年商业化:推出企业版计划,提供私有模型仓库和专属计算资源,年收入增长率达300%。

---

技术实现与创新点

Replicate的差异化竞争力源于其对AI模型分发范式的重构:

- 模型即服务(MaaS):将机器学习模型抽象为可调用的服务单元,类似AWS Lambda的函数即服务(FaaS)概念。

- 动态资源分配算法:根据模型推理请求的突发性,实时调整GPU/TPU资源分配,实现成本优化。

- 模型性能预估系统:通过历史运行数据训练的预测模型,可提前告知用户任务完成时间和费用,消除资源使用不确定性。

其核心架构包含三个核心组件:

1. 模型注册中心:存储所有容器化模型的元数据与接口定义

2. 调度引擎:基于优先级和资源可用性分配计算任务

3. 计费系统:按模型推理次数和资源消耗量计费,最小计费单元精确到秒

---

行业应用场景与价值

在实际商业场景中,Replicate已验证了多重价值:

- 内容创作:媒体公司The New York Times通过平台调用Stable Diffusion生成新闻配图,图片生产效率提升70%。

- 产品原型验证:金融科技初创公司使用平台的欺诈检测模型,在两周内完成风控系统可行性验证。

- 教育场景:OpenAI通过平台开放DALL·E 3模型测试权限,开发者社区在48小时内提交超过10万次推理请求。

---

市场影响与未来趋势

截至2025年Q2,Replicate已拥有:

- 150万注册开发者

- 覆盖230个国家和地区的用户基础

- 每月处理3.2亿次模型推理请求

该平台正推动三大行业变革:

1. 模型民主化:将原本需要数周的模型部署周期压缩至分钟级

2. 算力普惠化:中小团队可获得与头部企业相当的算力资源

3. 创新加速化:模型迭代周期从季度缩短至天级

未来技术方向包括:

- 边缘计算集成:支持在本地设备运行轻量化模型

- 模型即数据源(MaaS):将模型输出直接接入数据库或数据管道

- 多模态协作平台:实现文本、图像、视频模型的协同推理

Replicate的出现,标志着AI模型从“软件组件”向“云原生服务”的关键转型,其开源的模型容器规范(Replicate Format)正在成为行业标准,推动整个AI基础设施生态的持续进化。

应用截图