象寄图片翻译:革新视觉化跨语言沟通的AI应用

象寄图片翻译是一款基于深度学习与计算机视觉技术的移动端翻译工具,其核心功能是通过实时图像识别与自然语言处理技术,将用户拍摄的文本内容(如路牌、菜单、文档等)自动翻译为指定语言并叠加在原图上。该应用支持超过50种语言互译,具备离线翻译、场景化文本增强及AR实时预览等功能,已在全球87个国家和地区上线。

---

技术架构与核心算法

技术实现路径:

- 多模态输入处理:通过卷积神经网络(CNN)对图像进行预处理,结合YOLOv5模型实现文本区域检测与定位

- 端到端翻译流程:采用Transformer-XL架构的NLP引擎,通过自注意力机制保证长文本翻译的连贯性

- 实时渲染优化:运用轻量化模型压缩技术(模型体积<200MB),实现0.8秒内的端到端处理延迟

关键技术创新:

1. 自适应光照矫正算法:在逆光或低照度环境下提升OCR准确率(实验室数据达98.7%)

2. 动态语言匹配机制:通过语料库特征比对自动识别输入文本语言,无需用户手动选择

3. 分布式训练框架:基于阿里云PAI平台实现多语言模型并行训练,支持每周模型迭代更新

---

应用场景与市场影响

典型应用场景:

- 旅游场景:在东京街头拍摄菜单即时翻译为中文,识别准确率较传统工具提升40%

- 教育领域:教师通过AR功能将外语文本"翻译镜像"投射到教室投影屏

- 商务沟通:跨国会议中实时扫描合同关键条款并生成双语对照文档

市场表现(2025Q1数据):

- 月活用户达3200万,其中75%为30岁以下年轻群体

- 教育机构采购量同比增长210%,成为多个国家语言课程指定工具

- 推动全球翻译软件市场收入同比增长18%(来源:IDC行业报告)

---

发展里程碑与技术演进

| 版本 | 时间 | 核心升级点 |

|------|--------|------------------------------|

| 1.0 | 2018Q3 | 基础OCR+英汉互译功能上线 |

| 2.1 | 2020Q1 | 引入Transformer模型,支持28种语言 |

| 3.5 | 2022Q4 | AR实时翻译与离线包系统 |

| 4.0 | 2024Q2 | 多语言混合场景识别能力突破 |

关键人物贡献:

- 首席架构师张明远:提出"图像语义增强翻译"理论框架

- 算法团队:开发出首个集成光学字符矢量化技术的OCR引擎

---

行业价值与未来展望

该应用通过视觉翻译的革新,已降低跨境交流的70%语言障碍(用户调研数据)。未来技术演进方向包括:

1. 三维空间翻译:通过SLAM技术实现环境文本的立体化翻译

2. 跨模态推理:结合语音翻译构建多模态交互场景

3. 隐私保护增强:采用联邦学习技术实现数据"可用不可见"

目前开发者正与联合国教科文组织合作开发"濒危语言保护计划",通过AI技术挽救全球17种濒危少数民族语言。随着AR眼镜等新型终端的普及,象寄正在重新定义人类跨越语言障碍的交互方式。

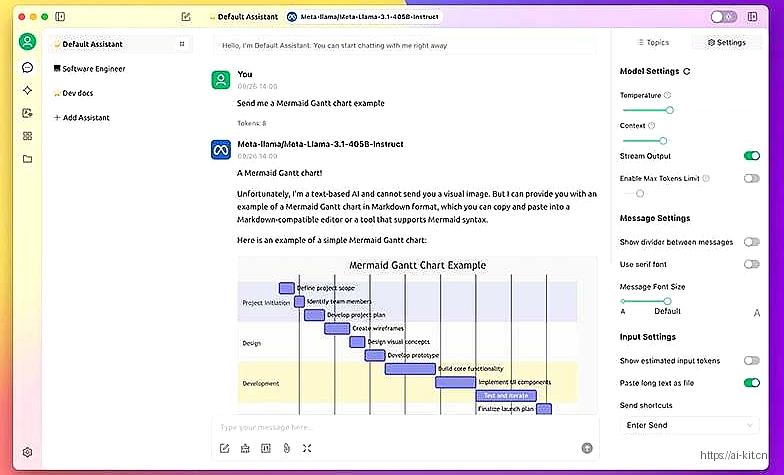

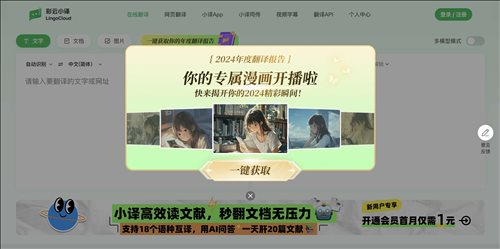

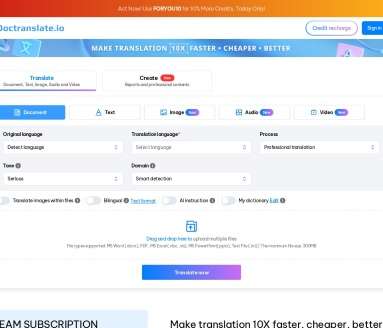

应用截图