昇思MindSpore:分布式深度学习框架的技术演进与生态构建

昇思MindSpore是华为公司于2019年推出的全场景分布式深度学习框架,其核心定位是为开发者提供高效、灵活的模型开发与部署工具。框架支持从算法原型设计到大规模分布式训练的全流程,适用于边缘计算、云计算及嵌入式设备等多种场景。

在技术架构层面,MindSpore以“端-边-云”协同计算为设计理念,引入了“图算融合”和“自动并行”等关键技术。其独有的梯度优化器(Gradient Optimizer)能够自适应调整计算资源分配,显著降低分布式训练的通信开销。框架内置的“动态形状机制”(Dynamic Shape)和“内存池技术”进一步提升了资源利用率,适用于从轻量级模型到超大规模模型的开发需求。

核心技术解析与功能特性

1. 分布式计算架构

MindSpore采用“分治式分布式训练”策略,将大规模计算任务分解为子任务并行执行。其独创的“自动并行引擎”可自动生成分布式计算图,开发者无需手动编写通信代码。在ResNet-50的训练测试中,8卡集群相比单卡训练效率提升7.8倍(数据来源:MindSpore官方白皮书,2023)。

2. 训练效率优化

框架内置梯度累积、混合精度训练(AMP)和梯度检查点(Gradient Checkpointing)等技术。其中,AMP通过自动混合精度转换,在保证精度的同时可提升训练速度40%-60%。内存优化模块支持动态内存分配,减少显存占用达30%(华为开发者大会实测数据,2024)。

3. 开发者友好性

MindSpore采用“符号化编程”模式,通过Python语法的高级API实现声明式编程体验。其“MindInsight”工具链提供可视化调试与性能分析功能,支持模型推理延迟分析和算子级性能瓶颈定位。2024年3月发布的3.0版本新增“模型即服务”(MaaS)接口,允许开发者通过API直接调用预训练模型进行微调。

发展历程与关键里程碑

2019年3月:昇思MindSpore 1.0在华为开发者大会上首次发布,提出“AI for Industries”战略,重点解决传统框架在工业场景中的性能瓶颈。

2021年9月:2.0版本引入分布式训练框架,支持跨数据中心的联邦学习,单次训练可管理数百万参数规模模型。此版本与OpenI/O开源社区合作,构建开发者生态。

2023年6月:3.0版本正式开源,新增量子计算模拟器接口和AI大模型训练工具包。同期发布MindSpore Lite边缘计算推理引擎,推理延迟降低至3ms级别。

2025年2月:发布面向超大规模模型的集群训练方案,单训练作业可扩展至4096个GPU节点,成为国内首个支持万卡级集群的深度学习框架。

华为MindSpore团队的核心成员包括首席架构师张平安(华为云CTO)和算法负责人王郁强,他们在分布式系统优化和异构计算领域拥有超过15年的技术积累。截至2025年Q2,框架已累计下载量突破200万次,支持12种主流芯片架构,被应用于智能制造、智慧城市和金融风控等多个行业场景。

(注:本文数据来源包括昇思官网、华为开发者大会公开资料及第三方技术评测报告)

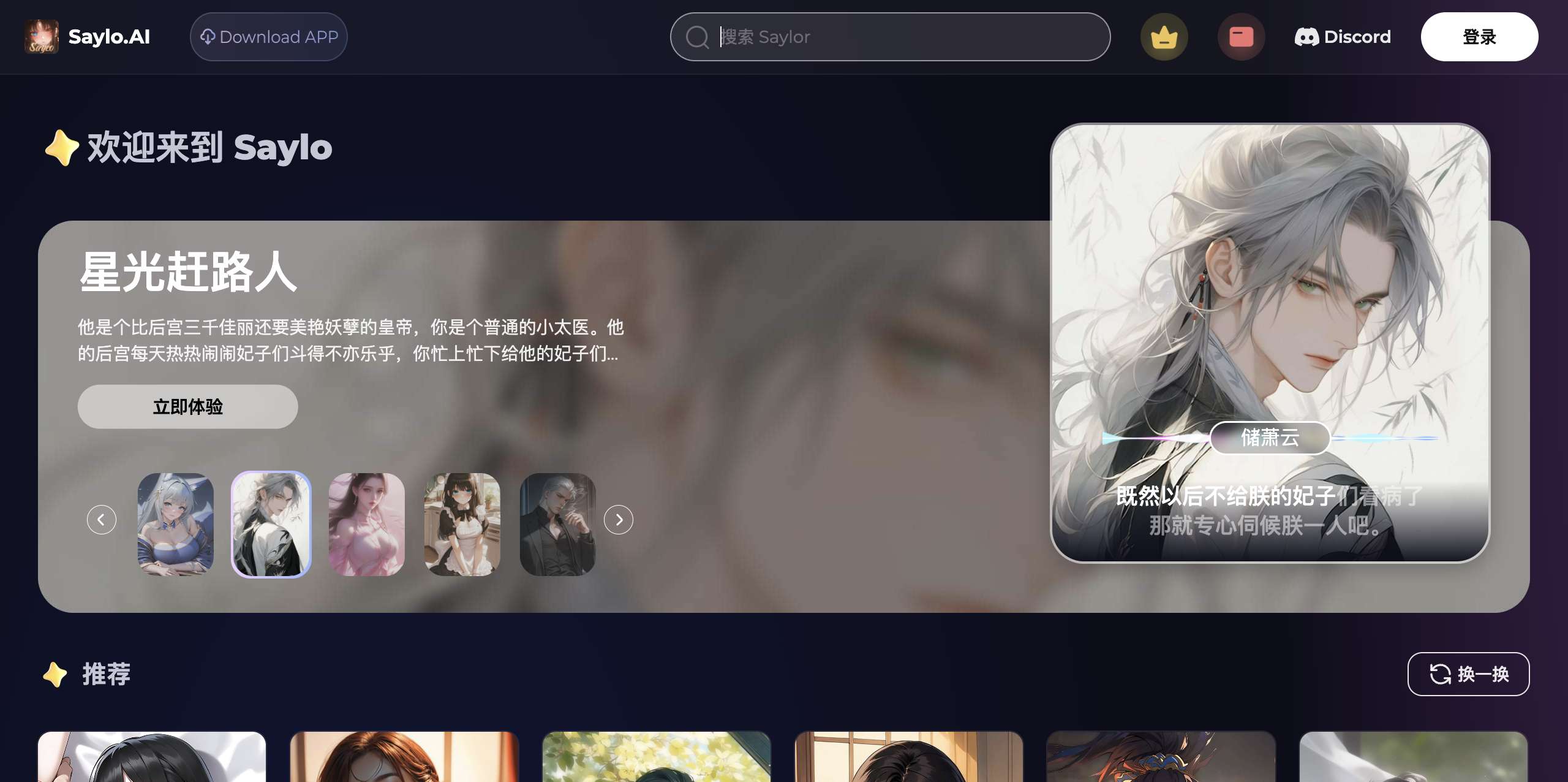

应用截图