概述

GPT-4(Generative Pre-trained Transformer 4)是OpenAI于2023年推出的第四代大型语言模型,代表了自然语言处理(NLP)和人工智能技术的重要突破。作为GPT系列的迭代版本,GPT-4在参数规模、多模态处理能力、上下文理解等方面实现了显著提升,被广泛应用于内容生成、数据分析、客户服务等多个领域。其技术架构基于深度学习和Transformer模型,通过大规模预训练和微调,能够模拟人类语言逻辑并执行复杂任务。

---

核心功能与技术特点

1. 强大的语言生成与理解能力

GPT-4通过大规模预训练和微调,能够生成连贯、高质量的文本,包括文章、代码、对话等。其上下文窗口扩展至32,768个token,支持更长的对话历史和复杂任务处理。

2. 多模态处理能力

相较于前代仅处理文本,GPT-4首次引入多模态支持,能够理解和生成图文结合的内容。例如,分析图像中的文字信息或生成描述性文本,拓宽了其在视觉辅助场景的应用。

3. 高度优化的推理能力

通过改进的注意力机制和模型架构,GPT-4在逻辑推理、数学计算和多步骤任务执行方面表现更优。例如,解决复杂数学问题或生成结构化的代码片段。

4. 高度可定制化

开发者可通过API接口快速集成GPT-4到应用程序中,并通过微调(Fine-tuning)适配特定领域的数据集,满足垂直行业的个性化需求。

---

技术架构与算法原理

1. Transformer架构的改进

GPT-4基于Transformer编码器结构,通过扩展隐藏层、增加参数量(据推测超过万亿级参数),显著提升了模型的表征能力。此外,引入了动态计算路径(Dynamic Computation Pathway)技术,以优化计算资源分配。

2. 对比学习与自监督训练

模型通过无监督学习从互联网文本中提取模式,并结合对比学习增强上下文关联性。其训练数据截至2024年初,涵盖广泛的领域知识。

3. 风险缓解机制

为减少偏见和有害输出,GPT-4内置了内容过滤系统,并通过强化学习(RLHF, Reinforcement Learning from Human Feedback)提升输出的伦理性和实用性。

---

发展历程与关键里程碑

- 2023年3月:GPT-4正式发布,支持多模态输入与输出,成为首个实现大规模图文处理的生成模型。

- 2023年6月:推出GPT-4 Turbo,优化推理速度和成本,适合高频次交互场景。

- 2024年2月:GPT-4 Vision版本发布,增强图像理解能力,可分析图表、识别场景中的文字。

- 2024年8月:OpenAI开源部分模型架构细节,推动社区合作与技术创新。

关键贡献者:

- Sam Altman(OpenAI CEO):主导GPT-4的商业化策略与伦理框架设计。

- Ilya Sutskever(OpenAI CTO):推动Transformer架构的优化与多模态能力的实现。

- OpenAI研究团队:通过持续迭代改进模型性能和安全性。

---

应用场景与市场影响

1. 企业服务

- 客户服务自动化:生成个性化回复,处理用户咨询(如Salesforce、Zendesk集成)。

- 内容生成:辅助撰写报告、邮件、营销文案(如内容创作平台Copy.ai)。

2. 教育与医疗

- 教育:提供语言学习辅助、自适应测试题生成(如Khan Academy合作案例)。

- 医疗:分析病历文本、生成初步诊断建议(需结合专业审核)。

3. 开发与创新

- 代码生成:支持Python、JavaScript等语言的自动化编码(GitHub Copilot基于GPT技术)。

- 艺术创作:结合图像输入生成创意描述或剧本(如DALL·E 3与GPT-4的联动)。

市场影响:

GPT-4加速了AI在各行业的渗透,据OpenAI统计,其API调用量在发布后6个月内增长300%。然而,也引发了对就业替代、隐私泄露和伦理风险的讨论,促使各国加强AI监管立法。

---

未来展望

GPT-4的演进方向包括:

1. 更强的实时交互能力:支持更自然的对话理解和多轮上下文追踪。

2. 安全与可控性提升:通过强化审核机制减少有害内容输出。

3. 垂直领域深度定制:针对金融、法律等场景开发专用版本。

4. 硬件协同优化:与量子计算或专用芯片结合,降低算力成本。

挑战与争议:

- 数据隐私与版权问题:训练数据的合法性与用户数据保护。

- 技术滥用风险:生成虚假信息或深度伪造内容。

---

参考资料

- OpenAI官方文档:[GPT-4技术白皮书](https://openai.com)(2023年发布)

- 《AI Index Report 2024》(斯坦福大学HAI研究院)

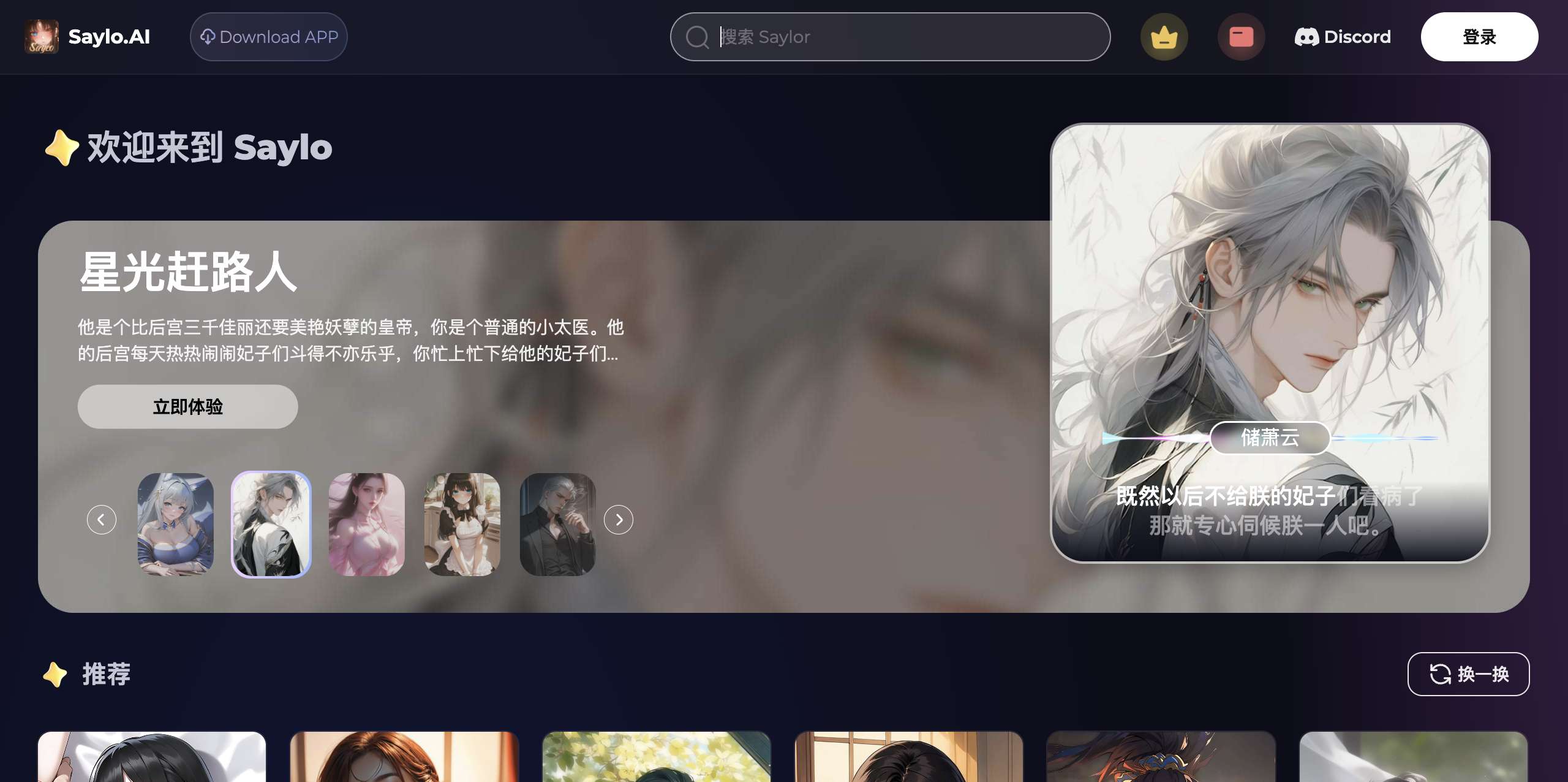

应用截图