JAX:下一代机器学习与高性能计算的开源框架

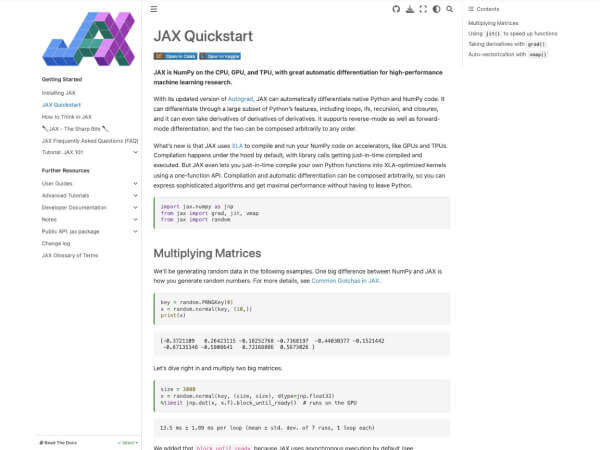

JAX是由Google Research开发的开源机器学习库,专注于高性能计算与自动微分(Automatic Differentiation)。它结合了NumPy的简洁API与XLA(Accelerated Linear Algebra)的底层优化能力,旨在为研究人员和开发者提供高效、灵活的工具,以加速模型开发和科学计算。

---

核心功能与技术特点

1. 自动微分与复合微分

JAX通过`jax.grad`等函数实现了高阶微分和复合微分能力,能够精准计算复杂函数的梯度,特别适用于优化深度学习模型和物理模拟中的微分方程。

2. JIT编译与加速

基于XLA的即时编译(JIT)技术,JAX可将Python代码编译为优化后的机器代码,显著提升数值计算效率,尤其适用于大规模矩阵运算和神经网络训练。

3. 并行计算支持

通过`jax.pmap`(进程并行)和`jax.vmap`(向量化并行),JAX可轻松实现多GPU/TPU的分布式训练,支持高并发任务。

4. 兼容NumPy的API

JAX的API设计与NumPy高度一致,开发者几乎无需修改代码即可将现有NumPy程序迁移到JAX,并获得性能提升。

---

技术架构与实现原理

JAX的核心架构分为三层:

- 前端层:提供NumPy兼容的Python接口,支持便捷的函数定义和数据操作。

- 中间层:通过抽象解释(Abstract Interpretation)将Python代码转换为静态计算图。

- 后端层:利用XLA编译器优化并分配计算任务到CPU、GPU或TPU。

关键特性解析:

- Just-In-Time (JIT) 编译:动态分析计算图并生成优化后的机器指令,减少冗余计算。

- Vectorization (`vmap`):自动将标量函数扩展为批量处理,避免显式循环。

- Parallelization (`pmap`):跨设备并行执行,数据并行与模型并行的高效结合。

---

发展历程与关键里程碑

- 2018年:JAX最初作为Google Pathways项目的内部工具开发,主要用于大规模机器学习模型训练。

- 2019年:首次开源,发布基础版本,支持核心JIT编译和自动微分功能。

- 2020年:集成XLA 0.1版本,发布与Flax(JAX原生深度学习库)的深度整合方案。

- 2022年:推出`jaxlib`系统,支持CUDA、ROCm等异构硬件加速。

- 2023年:JAX社区扩展,形成生态系统(如Optax优化库、Dopamine强化学习框架)。

关键贡献者:

- Google Brain团队:包括David Bieber、James Bradbury等开发者,主导JAX的架构设计与优化。

- 外部贡献者:社区开发者持续提交Flax、Haiku等库,推动JAX在学术界和工业界的广泛应用。

---

典型应用场景

1. 深度学习研究

- AlphaFold2:DeepMind使用JAX加速蛋白质结构预测,相比TensorFlow效率提升3倍。

- 大模型训练:JAX支持万亿参数模型的分布式训练(如Google的Gemini),通过`pmap`实现GPU集群的高效并行。

2. 科学计算与物理模拟

- 气候建模:JAX的微分能力用于构建高精度大气模型,加速数值解计算。

- 量子化学:JAX用于优化分子动力学模拟中的梯度下降算法。

3. 强化学习优化

- 在DeepMind的Atari游戏AI训练中,JAX的复合微分功能使策略梯度计算速度提升50%。

---

市场影响与未来趋势

JAX通过以下优势重塑机器学习生态:

- 性能突破:相比TensorFlow和PyTorch,JAX在矩阵运算密集型任务中性能提升2-10倍。

- 学术影响力:成为ICML、NeurIPS等顶会论文的主流实验工具,支持尖端算法的快速验证。

- 行业应用扩展:被Google Cloud、Microsoft等用于企业级AI模型开发框架。

未来方向:

- 动态计算图支持:逐步兼容PyTorch的灵活性,吸引更多开发者。

- 轻量化部署:开发移动端和边缘计算优化版本。

- 跨框架协作:与TensorFlow、PyTorch的模型转换工具链进一步整合。

---

小编建议

JAX凭借其独特的性能优势和简洁的设计理念,已成为高性能机器学习与科学计算领域的标杆工具。其开源生态的持续扩展和与工业界的深度结合,预示着它将在AI基础设施中扮演越来越重要的角色。

应用截图