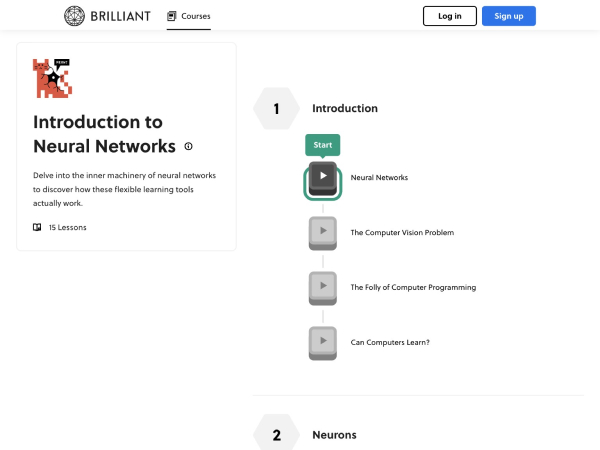

神经网络基础概念

神经网络是受生物神经系统启发的计算模型,由大量相互连接的节点(人工神经元)组成。其核心功能是通过输入数据的特征学习,逐步优化预测或决策能力。与传统编程不同,神经网络通过大量训练数据自动调整参数,实现对复杂模式的识别(如图像、语音或文本)。

发展历程与关键里程碑

神经网络的发展可以分为几个重要阶段:

1. 早期萌芽(1940-1950年代)

- 罗素·伯特兰(Russell Bertrand)提出神经元的数学模型,奠定理论基础。

- 1957年,弗兰克·罗森布拉特(Frank Rosenblatt)发明“感知机”(Perceptron),这是首个能够学习的神经网络模型。

2. 寒冬与复苏(1960-2000年代)

- 由于计算能力不足和理论限制,神经网络研究一度停滞(如1969年明斯基(Minsky)的批评)。

- 1986年,Rumelhart与McClennand等人提出反向传播算法,解决了梯度计算问题,推动神经网络复兴。

3. 深度学习时代(2006年至今)

- 2006年,辛顿(Geoffrey Hinton)团队提出深度信念网络(DBN),开启深度学习革命。

- 2012年,AlexNet在ImageNet竞赛中以优异成绩证明深度卷积网络的潜力。

- 近年来,Transformer架构(2017年)推动自然语言处理(如GPT系列)和多模态应用的突破。

技术原理与架构

神经网络的核心组成部分包括:

- 输入层:接收原始数据(如像素、词向量)。

- 隐藏层:通过激活函数(如ReLU、Sigmoid)提取数据特征。

- 输出层:生成最终结果(如分类标签或连续值预测)。

关键算法与机制:

- 反向传播:通过链式求导计算误差梯度,优化权重参数。

- 损失函数:衡量预测与真实值的差距(如交叉熵、均方误差)。

- 优化器:如Adam或SGD,用于高效更新参数。

应用场景与案例

神经网络已渗透到多个领域,典型应用包括:

1. 计算机视觉

- 案例:医疗影像分析(如肿瘤检测)、自动驾驶的实时目标识别。

2. 自然语言处理

- 案例:机器翻译(如Google Translate)、情感分析(如社交媒体舆情监控)。

3. 推荐系统

- 案例:Netflix的影视推荐、电商平台的个性化广告投放。

未来趋势与挑战

当前研究聚焦于:

- 高效模型:轻量化神经网络(如MobileNet)以适应边缘计算。

- 可解释性:提升模型决策的透明度(如通过Attention机制可视化)。

- 伦理与安全:防范数据偏见和对抗样本攻击。

参考资料

1. Hinton, G. E. (2006). "Reducing the Dimensionality of Data with Neural Networks." Science.

2. Goodfellow, I. (2016). Deep Learning. MIT Press.

3. Vaswani, A., et al. (2017). "Attention Is All You Need." NeurIPS.

通过持续的技术迭代与跨学科融合,神经网络正逐步解决更复杂的现实问题,成为人工智能领域的核心驱动力。

应用截图