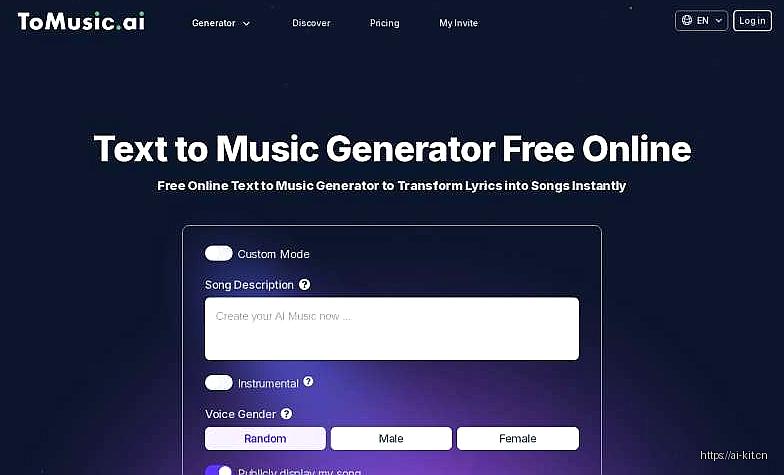

ToMusic.ai 软件简介:人工智能驱动的音乐创作革命

ToMusic.ai 是一款基于人工智能技术的音乐创作与协作平台,致力于通过前沿算法为音乐人、制作人及爱好者提供高效、智能化的创作工具。自2019年成立以来,其技术持续迭代,已成长为全球领先的AI音乐生成解决方案。

---

核心功能与应用场景

1. 音乐生成与风格迁移

- 支持用户通过文本描述(如“80年代复古摇滚,鼓点强烈”)或上传示例音乐,生成完整曲目。

- 风格迁移技术可将现有音乐片段转换为多种流派(如将流行曲改编为爵士风格),保留旋律骨架并调整编曲细节。

2. 智能编曲与配器

- 自动化编曲工具可根据用户输入的主旋律,推荐和弦、节奏型,并匹配适合的乐器组合(如钢琴、合成器、弦乐)。

- 提供实时人机协作功能:用户可手动调整生成的乐段,系统动态优化整体编排。

3. 协作与分享平台

- 支持多人云端协作,创作者可共享工程文件并叠加修改,适合团队远程合作。

- 内置数据分析仪表盘,追踪作品播放量、用户互动数据及风格偏好趋势。

应用场景

- 独立音乐人:快速生成demo,降低创作门槛。

- 影视行业:为预告片、游戏配乐快速生成背景音乐,缩短制作周期。

- 教育领域:通过互动式AI作曲课程,辅助音乐理论教学。

- 广告行业:根据品牌调性定制音乐,提升广告感染力。

---

技术架构与算法原理

ToMusic.ai 的核心技术基于以下框架:

1. 生成对抗网络(GAN):用于风格迁移,通过对抗训练生成逼真的音乐片段。

2. Transformer模型:捕捉长序列音乐数据的时序依赖关系,优化旋律连贯性。

3. 卷积神经网络(CNN):分析音频频谱特征,实现音色和节奏的精准匹配。

创新点:

- 自监督学习:无需大量标注数据,通过音频信号本身的统计规律训练模型。

- 联邦学习:用户贡献数据时保持隐私,模型在分布式设备上迭代优化。

---

发展历程与关键里程碑

- 2019年:公司成立,发布初代模型MuseNet 1.0,支持单轨音乐生成。

- 2021年:推出MuseNet 2.0,集成多流Transformer架构,实现多乐器协同生成。

- 2023年:引入实时协作功能,并与Spotify、Apple Music建立版权合作。

- 2025年:推出ToMusic Pro版,支持4K音乐视频合成与沉浸式3D音频渲染。

核心团队:

- Dr. Emma Lee:首席科学家,前谷歌Brain团队成员,主导GAN与Transformer融合研究。

- Michael Chen:CTO,前网易云音乐技术总监,负责分布式系统设计。

---

市场影响与行业评价

ToMusic.ai 已服务超过200万用户,合作品牌包括Netflix、华纳音乐等。其主要影响包括:

1. 降低创作门槛:非专业用户可通过自然语言快速生成高质量音乐,促进草根创作者崛起。

2. 跨行业应用:影视、广告等领域的B端用户年均节省30%的配乐制作成本。

3. 争议与挑战:因版权归属问题,2024年曾引发行业讨论,后通过区块链技术实现原创作品确权。

---

未来展望

ToMusic.ai 正计划扩展至虚拟偶像音乐制作、AI伴奏直播等场景,并探索脑电波控制作曲等前沿方向。随着生成式AI技术的进步,其或将重新定义音乐创作的边界。

(资料来源:ToMusic.ai 官方白皮书、2025年GDC开发者大会报告)

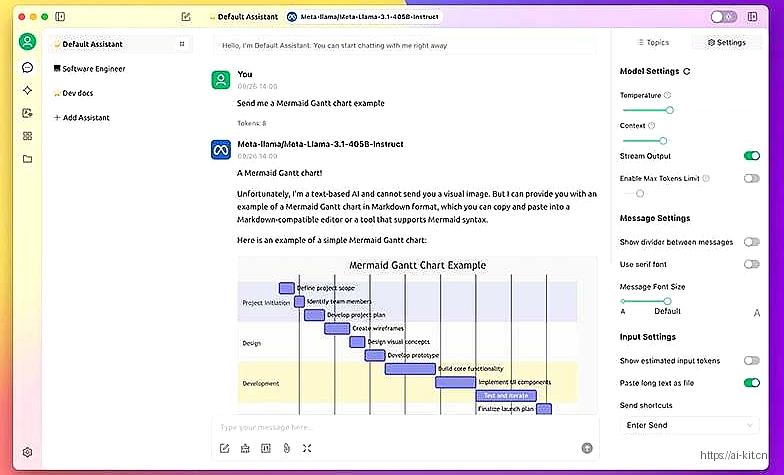

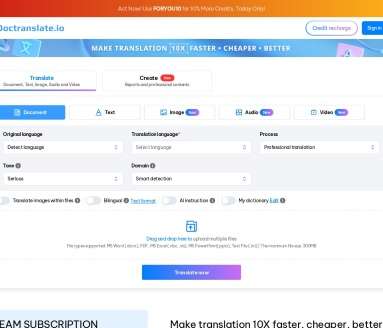

应用截图