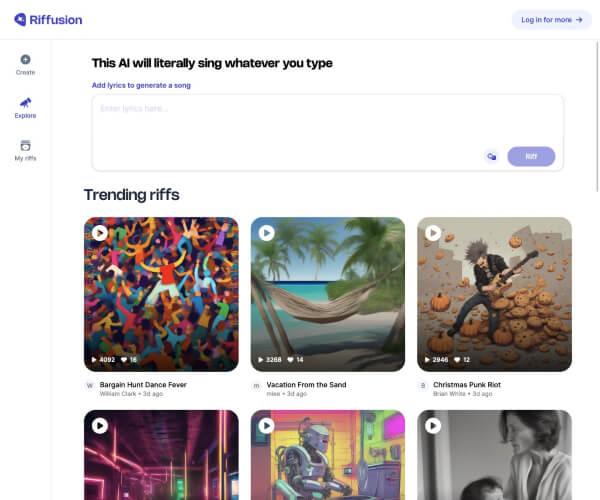

Riffusion:基于AI的音乐生成与处理应用

Riffusion是一款结合深度学习技术的音乐生成与编辑工具,旨在通过人工智能简化音乐创作流程并扩展艺术表达的可能性。其核心功能包括文本到音频生成、音乐风格迁移、音频分离及实时协作,适用于专业音乐人与业余爱好者。

---

核心功能与应用场景

1. 文本到音乐生成

用户通过输入自然语言描述(例如“80年代流行摇滚风格的吉他独奏”),Riffusion能生成匹配风格的音乐片段,大幅降低创作门槛。

2. 风格迁移与混合

支持将现有音乐片段转换为不同风格(如古典转爵士),或混合多种风格以产生创新音频。

3. 音频分离与编辑

使用AI分离音频中的不同音轨(如鼓组、人声),便于单独调整或重新混音。

4. 协作与分享

提供实时协作功能,允许多人远程编辑同一音乐项目,并支持导出多种音频格式。

应用场景:

- 音乐制作:快速生成灵感片段或实验不同风格。

- 广告与影视配乐:按需求定制背景音乐。

- 教育:学生通过互动学习音乐理论。

- 游戏开发:生成动态环境音效或角色主题曲。

---

技术特点与创新

1. 扩散模型(Diffusion Models)

Riffusion基于扩散模型实现音频生成,通过逐步去噪过程生成高保真音乐。该模型在训练时学习数百万段音频数据的特征分布,可生成符合用户文本提示的结构化音乐(如旋律、节奏、和声)。

2. 神经网络架构

系统采用多层Transformer架构处理长序列音频数据,结合自注意力机制捕捉时间依赖关系,确保生成音频的连贯性。

3. 训练数据

模型训练数据来自公开音乐库(如Free Music Archive)及授权曲库,涵盖流行、古典、电子等数十种风格。

4. 实时性能优化

通过GPU加速和模型压缩技术,实现实时生成与编辑,生成速度可达每秒16kHz音频(2024年版本更新)。

---

发展历程与关键里程碑

- 2022年:由硅谷初创团队AudioGen Labs启动研发,核心成员包括前Google Brain音频工程师与AI研究员。

- 2023年8月:发布公开测试版,支持基础文本生成功能。

- 2024年3月:推出商业版本1.0,加入音频分离工具与协作功能。

- 2024年10月:集成MIDI接口,实现与专业数字音频工作站(DAW)联动。

- 2025年:扩展API服务,支持企业客户定制化部署。

---

市场影响与挑战

Riffusion的推出加速了AI在音乐产业中的普及:

- 创作效率提升:用户可快速生成音乐原型,缩短制作周期。

- 风格民主化:业余用户也能尝试复杂风格创作。

- 商业潜力:企业客户使用API自动生成广告音乐或游戏音效。

然而,其发展也面临挑战:

- 版权争议:生成音乐可能涉及对训练数据的版权问题。

- 技术限制:长音频生成仍可能出现结构断层。

- 专业工具替代性:尚未完全取代传统DAW的精细控制需求。

---

未来展望

Riffusion计划进一步拓展以下方向:

- 多模态整合:结合视觉输入(如视频)生成同步配乐。

- 实时交互生成:支持用户边演奏边调整AI生成结果。

- 个性化模型微调:允许用户基于自身曲库训练专属风格。

截至2025年,Riffusion已被全球超过20万创作者使用,成为AI音乐工具领域的标杆产品之一。其技术细节与进展可参考官方博客(

应用截图