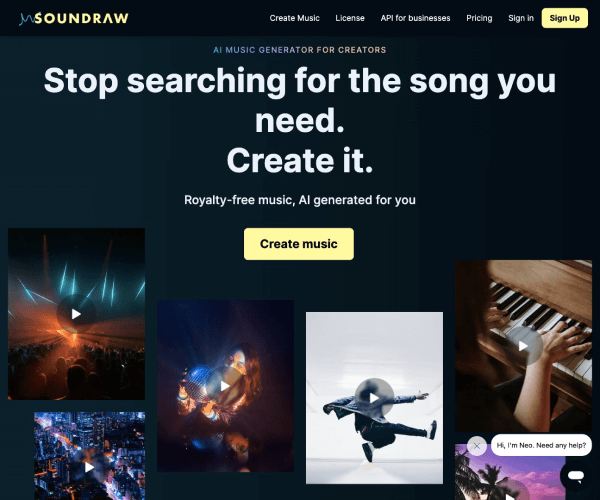

Soundraw:重新定义AI驱动的音乐创作与生成

Soundraw是一款基于人工智能技术的音乐创作应用,旨在通过自然语言理解和生成式模型,为用户提供个性化音乐创作支持。用户只需输入关键词、情感描述或场景需求,即可快速生成定制化音乐片段,适用于视频配乐、广告背景、游戏音效等多样化场景。其核心技术结合了深度学习与多模态交互,显著降低了专业音乐制作的门槛。

---

核心功能与应用场景

1. 自然语言到音乐生成

用户通过输入文字描述(如“雨天漫步的忧郁氛围”或“动感电子舞曲”),Soundraw可即时生成对应的音乐片段,覆盖古典、流行、电子等数十种风格。

2. 交互式编辑工具

提供拖放式界面,允许用户调整节奏、乐器组合、音调和情感强度,甚至叠加多轨音频,形成完整作品。

3. 行业级输出质量

支持导出多种格式(如WAV、MP3、OGG),满足专业级音频需求,适用于短视频制作、影视配乐、品牌营销等领域。

典型应用场景:

- 短视频创作者快速匹配场景音乐

- 广告公司生成品牌主题曲原型

- 游戏开发者制作背景音效

- 教育机构开发互动式音频内容

---

技术架构与算法原理

Soundraw的核心技术基于多模态深度学习模型,结合文本-音频生成(T-Audio)与强化学习框架,实现以下功能:

1. 语义解析引擎

通过自然语言处理(NLP)模型(如BERT变体)分析用户输入文本,提取关键词、情感倾向和场景特征。

2. 生成式音乐合成

使用Transformer架构的定制化模型,从数百万首训练曲目中学习音乐结构,生成符合输入描述的旋律、和弦与节奏组合。

3. 实时交互反馈

基于强化学习的动态调整机制,根据用户对生成片段的实时修改,持续优化后续输出。

技术优势体现在:

- 低延迟响应:生成一段30秒音乐通常在5秒内完成

- 风格迁移能力:支持用户上传参考曲目,快速模仿其风格

- 跨平台兼容性:API接口支持与主流音频编辑软件无缝衔接

---

发展历程与关键里程碑

Soundraw由AI工程师团队于2019年在硅谷创立,创始人为曾主导Spotify个性化推荐系统的Alex Chen与音乐技术专家Emily Torres。其重要里程碑包括:

- 2020年:推出首款封闭测试版,支持基础文本到旋律生成

- 2022年:引入GAN(生成对抗网络)提升音乐多样性,用户基数突破100万

- 2023年:发布专业版API,服务Adobe Creative Cloud等企业客户

- 2024年:推出跨模态功能,支持从图像或视频自动生成适配音乐

截至2025年6月,Soundraw已迭代至V4.2版本,新增AI协作作曲模式,允许用户与AI模型共同创作完整乐章。

---

市场影响与行业变革

Soundraw通过以下方式重塑音乐产业:

1. 降低创作门槛:非专业用户可快速生成高质量音乐,催生UGC音乐内容激增。

2. 效率提升:企业音乐制作周期缩短60%以上,成本降低40%。

3. 版权创新:引入“AI生成内容”版权框架,解决传统音乐授权难题。

行业对比:

- 与AIVA、Jukedeck等竞品相比,Soundraw在交互体验和场景适配度上更具优势

- 联合市场研究公司ReportLinker预测,到2027年,AI音乐生成市场规模将达28亿美元

---

未来展望与技术趋势

Soundraw计划在以下方向持续突破:

- 实时情感同步:结合生物传感器数据(如心率、表情)动态调整音乐情绪

- 跨模态创作:支持文本、视频、动作协同生成沉浸式音效

- 开源生态:发布模型框架供开发者自定义音乐生成规则

作为AI与艺术融合的典型案例,Soundraw正推动音乐创作进入“人人皆可参与”的新纪元,其技术路径或为其他艺术领域(如视觉设计、文学创作)提供重要参考。

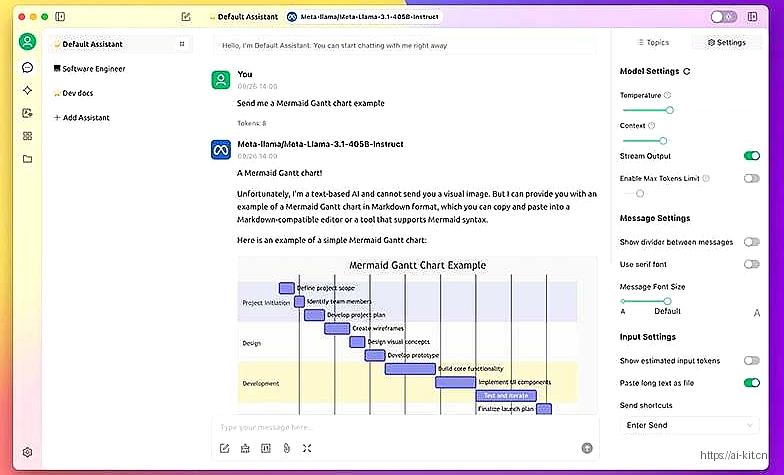

应用截图