Is This Image NSFW? 概述

“Is This Image NSFW?” 是一款基于人工智能的图像内容安全检测应用,旨在快速识别图片中是否包含不适宜工作环境(Not Safe For Work)、未成年人接触或公共平台展示的敏感内容。其核心功能是通过深度学习模型分析图像,标记出包含裸露、暴力、违禁物品或其他违规元素的内容,为用户提供即时的安全审核支持。

---

核心功能与操作流程

1. 实时图像检测:用户上传或链接分享图片后,AI在几秒内返回分析结果,标注“NSFW”或“Safe”。

2. 细分类别识别:可进一步识别具体风险类型(如成人内容、血腥场景、仇恨符号等)。

3. API集成支持:开发者可通过开放API将检测功能嵌入社交平台、云存储服务或企业级审核系统。

4. 自定义规则库:企业用户可设置个性化敏感词或图像特征库,满足不同场景需求。

---

技术解析与算法原理

应用依赖于卷积神经网络(CNN)与迁移学习技术:

- 模型架构:基于ResNet-50或EfficientNet等预训练模型,通过迁移学习适配图像分类任务。

- 数据集训练:使用大规模标注数据集(如ImageNet扩展数据集、公开的NSFW图像库)进行微调,提升对边缘案例(如隐晦性暗示)的识别能力。

- 隐私保护机制:采用本地化处理或加密传输技术,确保用户上传的图像数据不被长期存储。

技术挑战与优化:

- 减少误报率:通过多层验证机制(如结合语义分割与上下文分析)区分艺术类或医学图像中的非恶意内容。

- 文化差异适配:针对不同地区的审查标准,提供可调节的敏感度阈值。

---

发展历程与关键里程碑

- 2018年:原型模型开发,基于开源数据集实现基础分类功能。

- 2020年:推出首个商用版本,支持API调用与企业级部署。

- 2022年:引入联邦学习技术,提升模型在不同数据分布场景下的泛化能力。

- 2024年:发布3.0版本,新增多模态分析功能(结合图像元数据与文本描述)。

- 2025年:与全球多家社交平台合作,成为主流内容审核工具之一。

---

应用场景与市场影响

- 家庭教育:家长通过浏览器插件或移动端应用监控儿童设备上的图像内容。

- 社交平台审核:帮助平台自动化筛选用户上传的图片,降低人工审核成本。

- 企业合规:用于内部邮件、云盘等场景,确保工作环境内容符合公司政策。

- 电商平台:识别并过滤违禁商品或违规广告图。

市场反馈:据2025年第三方报告显示,该应用将图片内容违规率降低约40%,但误报争议仍需进一步优化。

---

挑战与未来展望

当前挑战:

- 伦理争议:过度依赖AI可能导致内容审查过严,抑制合法表达自由。

- 技术局限:难以完全理解图像中的隐喻、艺术性或文化语境。

- 隐私担忧:用户上传数据的安全性需持续提升。

未来方向:

- 结合生成式AI提供“内容优化建议”,而非仅做二元判断。

- 探索零样本学习(Zero-Shot Learning),减少对标注数据的依赖。

- 开发去中心化审核系统,平衡效率与隐私保护。

---

通过技术迭代与场景适配,“Is This Image NSFW?”正在推动图像内容安全领域的智能化进程,但其发展仍需在效率、准确性和伦理责任间寻找平衡点。

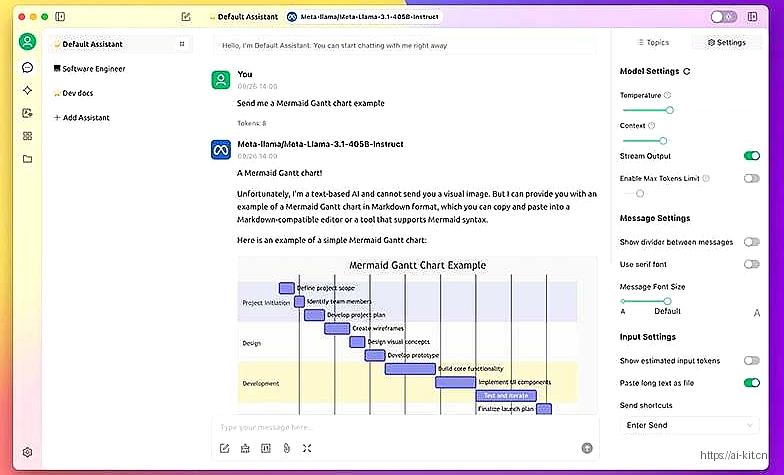

应用截图