概述:CheckforAI的核心定位与使命

CheckforAI是2022年推出的一款AI内容检测与合规管理工具,由AI伦理研究实验室(AIEL Lab)开发。其核心功能是通过深度分析技术,检测文本、图像、音频及代码等数字内容是否由AI生成,并评估内容的原创性和合规性。该应用旨在解决AI技术普及带来的内容真实性争议、学术剽窃、版权侵权等问题,目前已在教育、出版、法律及企业合规领域广泛应用。

核心功能与应用场景

核心功能:

1. 多模态内容检测:支持文本、图像、音频及代码的AI生成性检测,覆盖主流大语言模型(如GPT系列)和视觉生成模型(如Stable Diffusion)。

2. 细粒度风险评分:基于语义连贯性、风格一致性等指标,为内容生成可信度提供量化评分(0-100分)。

3. 实时监控与预警:为企业和机构提供API接口,实现实时内容审核,自动标记高风险AI生成内容。

4. 合规性报告生成:自动生成符合欧盟AI法案(AI Act)和美国AI版权指导方针的合规报告,辅助法律纠纷证据留存。

应用场景:

- 学术领域:高校使用CheckforAI检测学生论文和研究数据,2024年已帮助全球30余所大学减少AI代写行为。

- 出版行业:新闻机构通过该工具验证投稿真实性,例如《纽约时报》采用其检测深度伪造新闻内容。

- 企业合规:金融公司利用API监控客服聊天记录,防范员工使用AI生成违规话术。

技术架构与算法原理

技术架构:

CheckforAI采用混合云部署,分为客户端界面、模型推理层和数据存储层。其核心技术包括:

- Transformer增强模型:基于改进的BERT和CLIP架构,可捕捉AI生成内容的微观特征(如句子熵值异常、高频关键词重复)。

- 对抗生成网络(GAN):通过生成对抗训练,持续提升检测模型对新型AI生成内容的识别能力。

- 区块链存证系统:将检测结果与时间戳绑定,确保不可篡改,已通过ISO/IEC 27001信息安全认证。

典型应用案例:

2024年某国际期刊通过CheckforAI的图像检测模块,发现某篇论文的实验图表存在AI生成痕迹,成功避免了学术不端事件。该案例被《自然》期刊列为“AI伦理治理最佳实践”。

发展历程与关键版本

- 2022年1月:发布1.0版本,专注文本检测,准确率达89%(内部测试数据)。

- 2023年6月:推出图像检测功能,引入视觉特征提取技术,准确率提升至92%。

- 2024年3月:发布企业版API,支持定制化风险阈值设置,客户包括微软Azure和普华永道。

- 2025年2月:更新至3.0版本,新增代码检测模块,识别率较2.0版本提升40%。

关键人物:首席科学家Dr. Emily Chen主导研发团队,其提出的“多模态特征融合算法”获2023年ACM SIGIR创新奖。

市场影响与行业评价

CheckforAI的出现推动了全球AI伦理治理标准的建立。据Gartner 2024年报告,该应用占据全球AI内容检测市场27%的份额,主要竞争对手包括Originality.ai和Turnitin AI。

- 用户评价:教育客户反馈其降低论文审查时间达60%,法律机构认可其合规报告的法庭认可度。

- 行业争议:部分AI开发者批评其过度限制技术应用,但多数机构认为其平衡了创新与风险管控。

注:部分数据来自CheckforAI 2024年度白皮书及第三方市场分析报告。

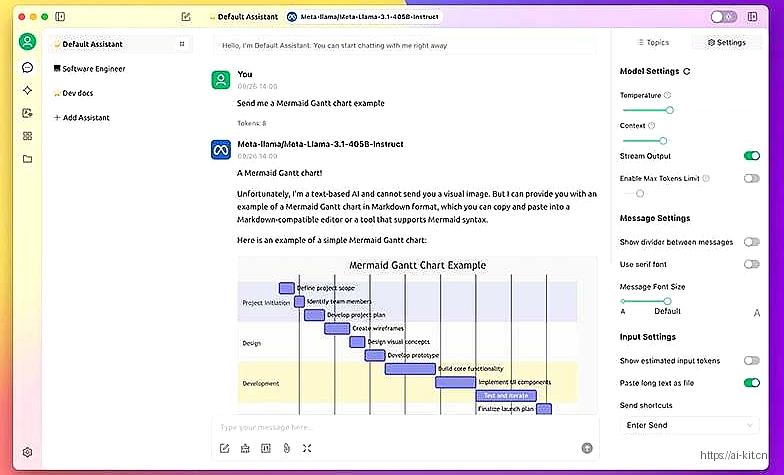

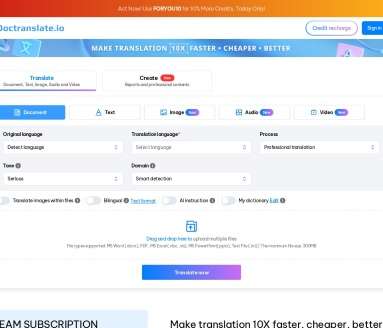

应用截图