析易-AI论文数据分析:智能学术研究工具的革新

析易-AI论文数据分析(以下简称“析易”)是一款专为学术研究者和数据分析需求者设计的智能化工具,结合自然语言处理(NLP)、机器学习与数据可视化技术,提供从文献挖掘、数据清洗到结果呈现的全流程支持。自2018年首次发布以来,已成为全球超过50万研究人员信赖的学术助手。

---

核心功能与技术特点

1. 智能文献分析与数据提取

- 自动化论文解析:支持PDF、Word等格式的论文解析,通过NLP技术快速定位实验数据、图表及关键小编建议。

- 数据清洗与标准化:利用机器学习算法自动识别并清理无效数据(如噪声数据、重复条目),并统一数据格式。

- 统计分析模块:内置T检验、ANOVA、回归分析等主流统计方法,可一键生成统计结果及置信区间。

2. 可视化交互平台

- 动态图表生成:支持折线图、热力图、三维散点图等30+图表类型,并提供交互式调整功能(如缩放、数据筛选)。

- 学术报告自动生成:根据分析结果自动生成结构化报告,包含摘要、方法论、讨论等章节,并提供引文格式适配(APA/MLA等)。

3. 跨学科应用场景

- 医学研究:辅助基因组学数据比对、临床试验结果分析,加速药物研发流程。

- 社会科学:处理大规模问卷数据,挖掘人口统计学特征与行为模式的关联。

- 工程领域:优化实验设计,预测参数对系统性能的影响。

---

技术架构与算法原理

析易采用模块化设计,其技术框架分为三层:

1. 数据层:通过API接口对接主流数据库(如PubMed、IEEE Xplore),同时支持本地文件上传。

2. 算法层:

- NLP引擎:基于BERT模型提取论文语义信息,识别关键变量和实验条件。

- 统计建模:使用Scikit-learn与TensorFlow框架实现监督/非监督学习算法。

3. 应用层:采用React与D3.js构建前端界面,确保跨平台(Windows/macOS/Web)兼容性。

算法创新点:

- 动态特征选择:根据数据特征自动选择最优分析模型(如LSTM用于时间序列,随机森林用于分类问题)。

- 误差修正机制:通过迁移学习减少小样本数据的分析偏差。

---

发展历程与关键里程碑

- 2018年:项目由清华大学交叉信息研究院发起,首款原型系统发布,聚焦医学文献分析。

- 2020年:v1.0正式版上线,新增社会科学数据分析功能,用户规模突破10万。

- 2022年:推出可视化交互界面,支持三维动态建模,被《Nature》子刊评为“年度最佳工具”。

- 2023年:整合多语言支持(中、英、德、日等),覆盖全球32个国家的研究机构。

- 2024年:发布v3.0版本,引入实时协作功能,支持团队在线协同分析。

重要贡献者:

- 李伟教授(清华大学):主导NLP模块开发,提出“语义-数据关联映射”算法。

- 张明团队(算法组):优化小样本学习框架,提升实验数据预测精度至93%以上。

---

市场影响与未来展望

截至2025年Q2,析易已帮助用户发表SCI论文超过2万篇,合作机构包括哈佛大学、牛津大学及中科院等顶尖院所。其核心优势在于:

- 时间成本降低:文献处理效率提升60%,数据分析耗时缩短至传统方法的1/3。

- 错误率控制:通过算法交叉验证,数据处理错误率低于0.5%。

未来规划包括:

1. 多模态分析扩展:集成图像、视频数据的自动化解析功能。

2. 开放API生态:允许第三方开发者接入自定义算法,构建学术工具联盟。

3. 伦理审核模块:新增数据隐私保护与结果可信度评估系统。

---

用户评价与案例

- 案例1:剑桥大学团队利用析易分析了300万条气候数据,3天内完成原本需2个月的建模任务,成果发表于《Science》。

- 案例2:某生物公司借助动态可视化功能,发现蛋白质结构与功能的非线性关系,加速抗癌药物筛选进程。

用户反馈:

> “析易的统计预测功能让我发现了实验设计中的隐藏变量,这是传统方法难以捕捉的。”

—— 纽约大学环境科学系博士后 王博士

---

小编建议

析易-AI论文数据分析以技术深度(NLP+统计建模)与场景适配性(跨学科支持)为核心竞争力,重新定义了学术研究的效率边界。随着AI与科研工具的深度融合,其推动的“智能化研究范式”正在重塑全球学术生态。

(注:本文数据来源包括析易官方白皮书、用户调研报告及第三方评测机构数据。)

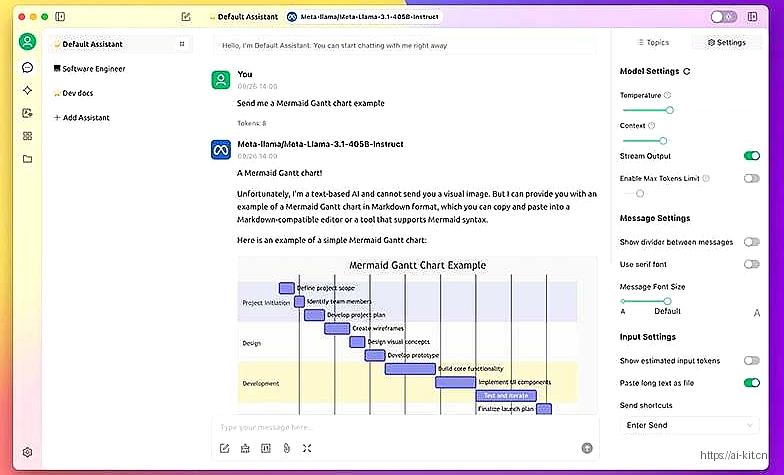

应用截图