AI应用的挑战与问题分析

人工智能技术在快速发展的同时,也面临着一系列复杂的技术、伦理和社会问题。以下从多个维度探讨AI应用的潜在挑战,并结合行业案例进行解析。

---

技术局限性:算法的边界与瓶颈

1. 数据依赖性

AI模型的性能高度依赖训练数据的质量与多样性。例如,图像生成工具若缺乏特定文化背景的图像数据,可能导致输出内容偏见(如肤色、服饰设计的刻板印象)。

案例:2023年某绘画AI因数据集不足,生成的中东人物形象普遍不符合当地文化特征,引发争议。

2. 泛化能力不足

部分AI在复杂现实场景中表现不稳定。例如,自动驾驶系统在极端天气或罕见路况下可能出现决策失误,这类问题至今仍是行业研究重点。

3. 算力成本

大规模AI模型的部署需消耗巨额算力资源。据OpenAI统计,2024年训练一个超大规模语言模型的碳排放量相当于500户美国家庭的年用电量,环保压力显著。

---

伦理与公平性问题

1. 算法偏见

训练数据中的历史偏见可能导致AI决策歧视。例如,2022年某招聘平台的AI筛选系统因数据偏向男性工程师,导致女性候选人通过率降低40%。

2. 隐私泄露风险

用户数据的采集与存储存在安全隐患。2024年某健康监测类AI应用因数据库漏洞,泄露超500万用户生物特征数据,凸显隐私保护的紧迫性。

3. 透明性缺失

“黑箱问题”使AI决策过程难以解释。医疗诊断AI若无法说明判断依据,可能引发医患纠纷。欧盟《AI法案》已要求高风险AI系统必须具备可追溯性。

---

社会影响与行业挑战

1. 就业冲击

自动化工具替代部分岗位的风险加剧。据世界经济论坛预测,2025年全球约8500万岗位将因AI技术被取代,同时创造9700万新岗位,但技能转型面临巨大挑战。

2. 版权归属争议

AI生成内容的著作权归属尚无明确法律界定。例如,美国版权局2023年裁定AI创作的绘画作品不可申请版权,引发艺术界激烈讨论。

3. 技术滥用风险

生成式AI被用于伪造信息(如Deepfake视频),加剧虚假信息传播。Meta的“AI检测工具”虽能识别75%的假视频,但仍存在技术缺口。

---

行业应对策略与趋势

1. 技术层面

- 小模型轻量化:如Google的Gemini Nano将算力需求降低90%,推动边缘计算场景应用。

- 数据增强技术:通过合成数据(如AI生成虚拟用户行为)缓解数据偏见。

2. 政策规范

全球已有超60国制定AI伦理框架。例如,中国《生成式AI服务管理暂行办法》要求企业建立内容安全审核机制,欧盟则强制要求AI系统标注生成内容来源。

3. 公众教育

企业开始加强用户教育,如OpenAI在ChatGPT中增加“来源标注”功能,帮助用户识别AI生成内容。

---

未来展望

AI技术的健康发展需技术突破与制度完善的双重驱动。2025年国际标准化组织(ISO)预计推出首个AI伦理认证体系,或将成为行业规范化的重要里程碑。企业与监管机构需协同合作,推动AI在可控、可信的轨道上持续创新。

(数据来源:OpenAI技术报告、世界经济论坛白皮书、欧盟AI法案草案)

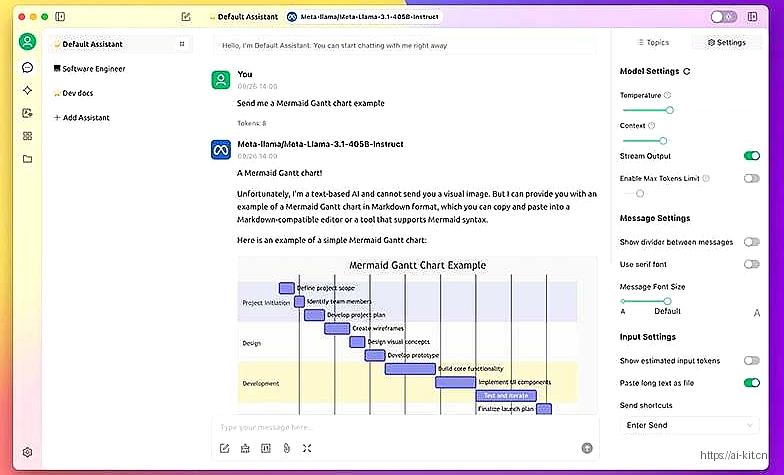

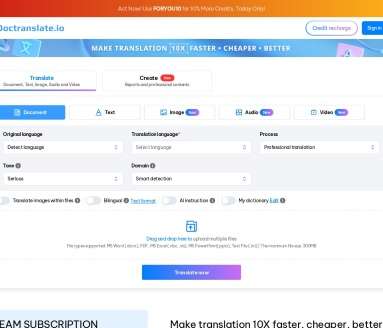

应用截图